Deepfakes: wat moeten we ermee?

In dit artikel leggen we uit wat deepfakes zijn, hoe deze werken, en wat ze betekenen voor onze 'post-truth' maatschappij

Auteur: Julia Alexeenko

Steeds vaker lees je over de deepfakes, en steeds vaker zie je ze verschijnen. Is het belangrijk om het, in het kader van ‘post-truth’, over deepfakes te hebben in je klas? Zo wel, hoe dan? En wat zijn deepfakes, eigenlijk?

Het woord 'deepfake' beschrijft een proces en het resultaat van het trainen van kunstmatige intelligentie software om beelden, geluiden, of teksten te creëren of te manipuleren.

Deepfakes kan je niet begrijpen zonder over GANs (generatief antagonistennetwerk) te praten. Heel kort door de bocht: GANs zijn twee algoritmes die elkaar proberen te overtreffen.

Bijvoorbeeld: we leren een antagonistennetwerk hoe een hamburger eruit ziet. Dat doen we door ons netwerk — twee algoritmes dus — afbeeldingen van hamburgers te voeden. Hoe meer hamburger-data de algoritmes krijgen, hoe beter ze ‘weten’ hoe een hamburger eruit ziet. Vervolgens gaat het ene netwerk (de ‘generator’) een afbeelding genereren dat op een hamburger lijkt. Het andere netwerk (de ‘discriminator’) legt dit gegenereerde plaatje neer naast de echte foto en zegt: nee schat, je bent er nog niet, try better. Dit gaat door totdat de ‘discriminator’ ongeveer de helft van de tijd bij en gegenereerd beeld ‘denkt’ dat het echt is. Dan is je synthetische hamburger klaar.

Maar ja, dat kan natuurlijk niet alleen met broodjes. Met GANs kan je alles maken: vogels, muziek, memes, teksten — en, uiteraard, gezichten.

En dat is eng. Want ja, met deze tech kan je niet alleen realistische gezichten genereren, maar ook heel realistisch gezichten van mensen aan video’s toevoegen. Zo werd bijvoorbeeld actrice Gal Gadot gedeepfaked in een pornografisch filmpje. Zonder haar toestemming, natuurlijk. En in onderstaande video is te zien hoe ‘Mark Zuckerberg’ zijn excuses aanbiedt voor zijn dubieuze zaken.

Dit kan in principe iedereen overkomen van wie er genoeg foto’s op internet staan (en daar hebben algoritmes steeds minder van nodig om een realistisch beeld te maken). Reden voor paniek? Als het aan de media ligt, ja. Want deepfakes brengen mensen in gevaar: activisten (vooral vrouwen en LHBT+ers), maar ook politici, celebrities, CEO’s.

Hoe gevaarlijk en raar ze ook zijn, we kunnen deepfakes niet verbieden. Want deze technologie geeft de mogelijkheid om de kosten voor productie van beeld en tekst te besparen. Ook is het een handige tool om algoritmen die zich als mens voordoen een gezicht te geven: denk aan Siri of Alexa. Want als we een menselijk gezicht zien, worden we empathisch, en daardoor kopen we makkelijker en meer.

Kunnen we dan niet de media verplichten om bij alles te checken of het echt of een deepfake is? Dat werkt ook niet perfect. Techplatformen zoals Facebook, Reddit of Twitter hebben eigen richtlijnen ontwikkeld om het verspreiding van dat soort content tegen te gaan. Het probleem hiermee is dat we als maatschappij dan blindelings vertrouwen op de visie van platformen in kwestie — vaak zonder dat we er ook maar iets over weten. Welke deepfake is schadelijk? Wiens reputatie is het beschermen waard en wiens niet? En vooral: wie bepaalt wat een deepfake is en wat niet: algoritmes of zwaar onderbetaalde mensen in verre landen? Allemaal lastige vragen.

Ook als je deepfakes op tijd verwijdert, is er nog sprake van de zogenaamde ‘liers dividend’. Als iedereen weet dat alles potentieel nep kan zijn, kan iedereen op het moment dat er een video verschijnt waar ze niet trots op zijn, roepen ‘dit is deepfake!’. Anderen beschuldigen van deepfake of nepnieuws kan retorische dekking bieden. Een voorbeeld daarvan (al voor de opkomst van deepfakes) was natuurlijk Donald Trump, die bij alles riep dat het nepnieuws was.

Dus deepfakes verbieden en reguleren werkt niet echt. Wat kunnen we dan wél doen om te zorgen dat we het verschil nog weten tussen echt en nep?

Op het moment dat we iets begrijpen, is het vaak eigenlijk ook meteen een stuk minder eng. En als iets niet meer eng is, dan kunnen we er makkelijker creatief mee aan de slag. Heel praktisch betekent het:

- Dat voorlichting geven over hoe eng deepfakes zijn alleen maar meer paniek en dus ongeloof zaait. Dat leidt tot meer ‘liers dividend’, en dat willen we niet.

- Dat over deepfakes praten in de klas kinderen niet bang of wantrouwend, maar juist kritisch moet maken.

Wat dus nodig is: een meer hands-on aanpak. Denk bijvoorbeeld aan het laten maken van deepfakes door kinderen zelf. En het samen kijken wat voor data erin gaat en hoe het algoritme ermee omgaat. Maar ook voorbeelden laten zien van hoe deepfakes een medium kunnen zijn om wél iets maatschappelijk-nuttigs te doen.

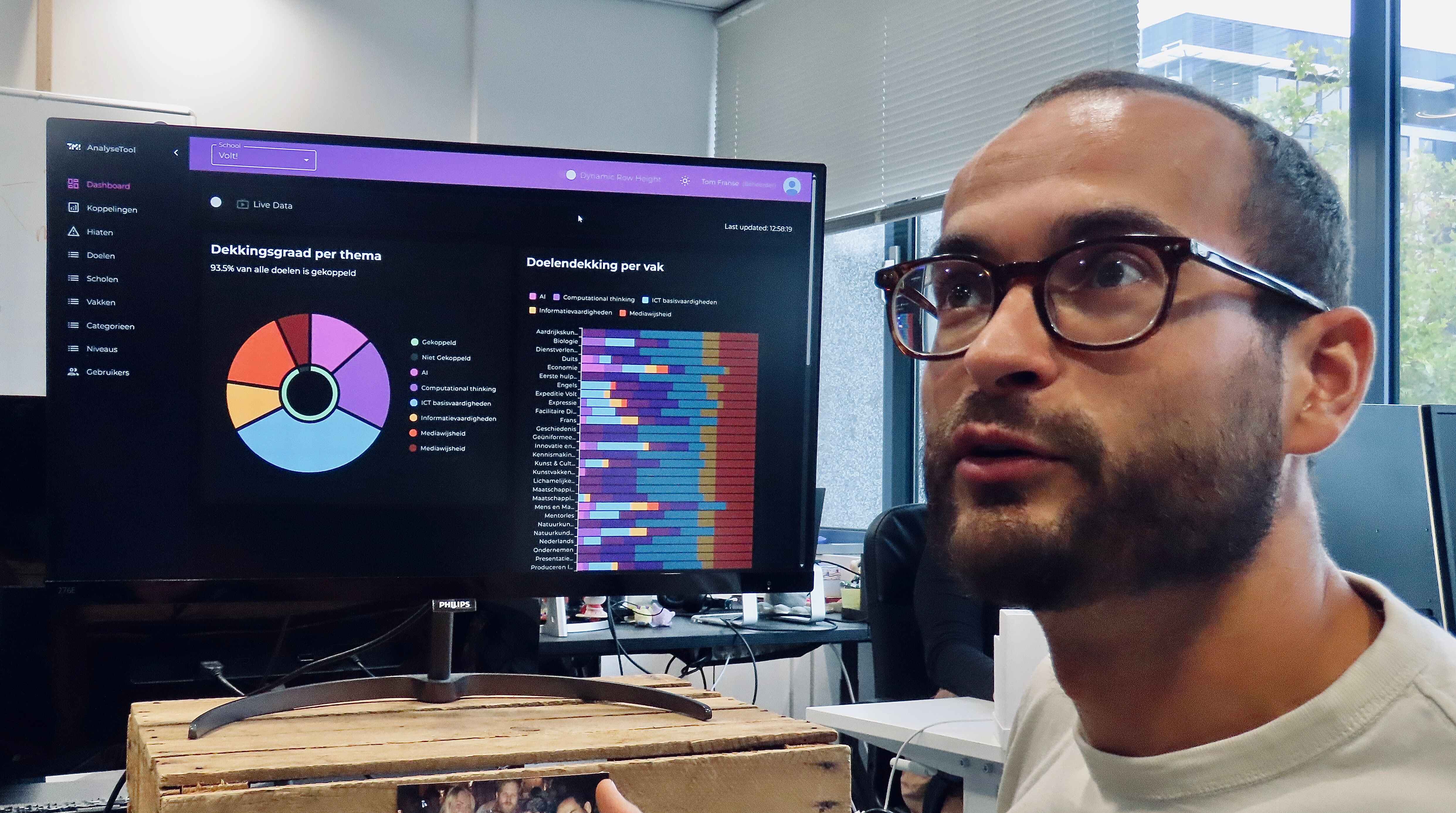

Desinformatie bestond lang voordat alles online ging. Met deepfakes is er dus weinig veranderd — behalve dat het tegenwoordig misschien sneller viral gaat. Bij TMI weten we leerlingen op een pakkende en creatieve manier desinformatie-bestendig te maken.

.jpg)

.jpg)

.png)

.png)

.png)

.jpg)

.webp)

.webp)

.webp)

.avif)